需求

利用FFmepg解析并解码音频流数据,然后将解码后的音频数据送给Audio Queue以实现播放.

实现原理

利用FFmpeg解析音频数据流, 利用FFmpeg解码音频数据为PCM格式. 利用Audio Queue Player实现音频数据播放.

阅读前提

代码地址 : Audio Decoder

掘金地址 : Audio Decoder

简书地址 : Audio Decoder

博客地址 : Audio Decoder

总体架构

本例以一个苹果原生相机录制的.MOV文件为例, 将该文件使用FFmpeg解析并解码,将解码后的数据放入传输队列中,然后开启audio queue player, 播放器在回调函数中轮循取出队列中的数据实现播放.

简易流程

FFmpeg parse流程

- 创建format context:

avformat_alloc_context - 打开文件流:

avformat_open_input - 寻找流信息:

avformat_find_stream_info - 获取音视频流的索引值:

formatContext->streams[i]->codecpar->codec_type == (isVideoStream ? AVMEDIA_TYPE_VIDEO : AVMEDIA_TYPE_AUDIO) - 获取音视频流:

m_formatContext->streams[m_audioStreamIndex] - 解析音视频数据帧:

av_read_frame

FFmpeg解码流程

- 从parse中的

AVFormatContext获取音频流对象AVStream.m_formatContext->streams[m_audioStreamIndex]; - 获取解码器上下文:

formatContext->streams[audioStreamIndex]->codec - 获取解码器实例:

avcodec_find_decoder(codecContext->codec_id) - 打开解码器:

avcodec_open2 - 初始化音频帧:

AVFrame *av_frame_alloc(void); - 将数据发给解码器:

int avcodec_send_packet(AVCodecContext *avctx, const AVPacket *avpkt) - 获取解码后的数据:

int avcodec_receive_frame(AVCodecContext *avctx, AVFrame *frame); - 创建转码器:

struct SwrContext *swr_alloc(void); - 设置转码器参数:

swr_alloc_set_opts - 初始化转码器上下文:

int swr_init(struct SwrContext *s) - 开始转码:

int swr_convert(struct SwrContext *s, uint8_t **out, int out_count,const uint8_t **in , int in_count); - 获取转码后的data与size.

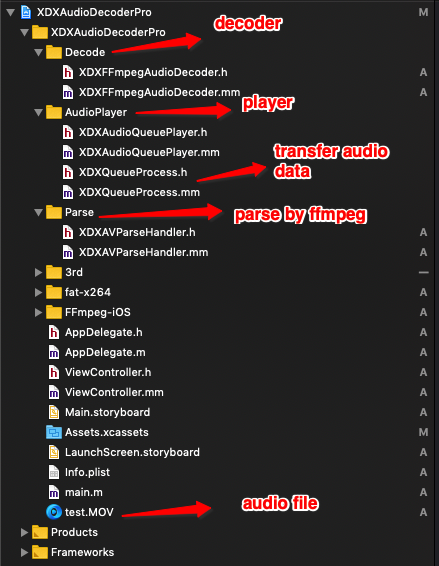

文件结构

快速使用

设置音频格式ASBD

1

2

3

4

5

6

7

8

9

10AudioStreamBasicDescription audioFormat = {

.mSampleRate = 48000,

.mFormatID = kAudioFormatLinearPCM,

.mChannelsPerFrame = 2,

.mFormatFlags = kLinearPCMFormatFlagIsSignedInteger | kLinearPCMFormatFlagIsPacked,

.mBitsPerChannel = 16,

.mBytesPerPacket = 4,

.mBytesPerFrame = 4,

.mFramesPerPacket = 1,

};配置播放器

1

[[XDXAudioQueuePlayer getInstance] configureAudioPlayerWithAudioFormat:&audioFormat bufferSize:kXDXBufferSize];

Parse并解码音频文件数据

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16- (void)startDecode {

NSString *path = [[NSBundle mainBundle] pathForResource:@"test" ofType:@"MOV"];

XDXAVParseHandler *parseHandler = [[XDXAVParseHandler alloc] initWithPath:path];

XDXFFmpegAudioDecoder *decoder = [[XDXFFmpegAudioDecoder alloc] initWithFormatContext:[parseHandler getFormatContext] audioStreamIndex:[parseHandler getAudioStreamIndex]];

decoder.delegate = self;

[parseHandler startParseGetAVPackeWithCompletionHandler:^(BOOL isVideoFrame, BOOL isFinish, AVPacket packet) {

if (isFinish) {

[decoder stopDecoder];

return;

}

if (!isVideoFrame) {

[decoder startDecodeAudioDataWithAVPacket:packet];

}

}];

}获取解码后数据并播放

为了每次能够重新播放,这里需要标记当前是否为解码的第一帧数据,以重新启动播放器. 另一点是使用NSTimer等待音频数据放入队列再开始播放,因为audio queue是驱动播放模式,所以必须等音频数据放入传输队列再开始播放.

1 | #pragma mark - Decode Callback |

具体实现

1. 初始化解码器

从Parse模块中可以获取当前文件对应FFmepg的上下文对象AVFormatContext.因此音频流解码器信息可以直接获取.

获取音频流对象

1

AVStream *audioStream = m_formatContext->streams[m_audioStreamIndex];

获取解码器上下文对象

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15- (AVCodecContext *)createAudioEncderWithFormatContext:(AVFormatContext *)formatContext stream:(AVStream *)stream audioStreamIndex:(int)audioStreamIndex {

AVCodecContext *codecContext = formatContext->streams[audioStreamIndex]->codec;

AVCodec *codec = avcodec_find_decoder(codecContext->codec_id);

if (!codec) {

log4cplus_error(kModuleName, "%s: Not find audio codec",__func__);

return NULL;

}

if (avcodec_open2(codecContext, codec, NULL) < 0) {

log4cplus_error(kModuleName, "%s: Can't open audio codec",__func__);

return NULL;

}

return codecContext;

}初始化音频帧

AVFrame 作为解码后原始的音视频数据的容器.AVFrame通常被分配一次然后多次重复(例如,单个AVFrame以保持从解码器接收的帧)。在这种情况下,av_frame_unref()将释放框架所持有的任何引用,并在再次重用之前将其重置为其原始的清理状态。

1 | // Get audio frame |

2. 将原始数据发给解码器

调用avcodec_send_packet将压缩数据发送给解码器.最后利用循环接收avcodec_receive_frame解码后的音视频数据.

1 | int result = avcodec_send_packet(audioCodecContext, &packet); |

3. 接收解码后的数据.

1 | result = avcodec_receive_frame(audioCodecContext, audioFrame); |

4. 将解码后的数据转码为iOS设备可播放的类型

1 | result = avcodec_receive_frame(audioCodecContext, audioFrame); |